先月 5/20、5/21に開催された Google I/O 2025 に現地参加してきた。

イベント前日

当日は混むので前日にbadge pick upをすませた方が良いとのことで、前日の午前に到着する便で向かった。

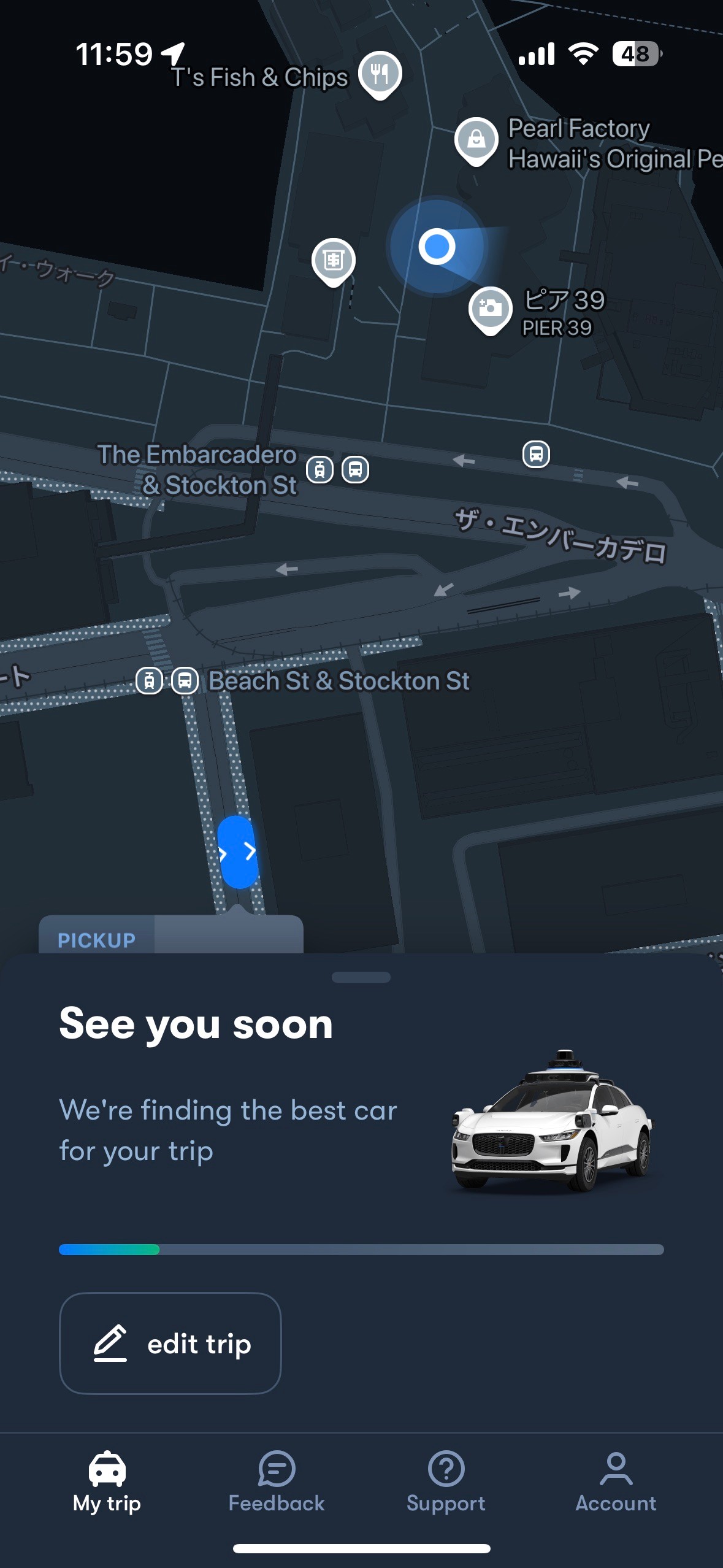

初日はサンフランシスコ市内でランチを食べに。 サンフランシスコ市内と会場のマウンテンビューは距離があってタクシーで40分くらいかかるのだが、Waymoに絶対乗りたかったのでサンフランシスコ市内まで行ってきた。(2025年5月時点でサンフランシスコ市内でしか提供されていない)

|

|

カーブや停車もスムーズで、街中で人間と機械が共存している姿は未来を感じられて良かった。日本にも早くきてほしい。

午後はbadge pick upに向かう。

ノベルティは、ステッカー・帽子・タンブラーが配られた。邪魔になると思ってホテルにおいて当日会場に行ったのだが、めちゃめちゃ暑くて帽子とタンブラーはここで使うために配られたのだと認識して後悔した。 飲み物はモーニングやランチの時間などはアイスコーヒーやフルーツジュースなど配られるものの、セッションの時間などは水を組むエリアがあってここでタンブラーを使うシステムだった。

ホテルはGoogle I/O推奨で割引が効いているSunnyvaleのホテルへ。過去の参加ブログを読んで、なるべく推奨ホテルにするのが良いとのことだったのでそうしたが、シャトルバスは出ておらず結局Uberで現地に向かうのだった。朝や帰りは混んでいてUberも割増料金で円安の凄まじさを感じた。 また、街中をCybertruckが普通に走っていたり車も基本デカいので日本車が小さく見えた。

前職の同僚がSunnyvaleに住んでいるとのことだったので、夜は数年ぶりに飲みに行ってベイエリアのエンジニア事情なども聞けて良かった。 ホテルからダウンタウンまでも徒歩だと30分くらいで車がないと移動できないのがちょっと大変。

イベント当日

入場の際は、スタッフの皆さんがすれ違いざまにハイタッチしてきたり気さくに話しかけてくれたりとみんなハイテンションで熱量を高めてくれた。

入場時は持ち物検査があり、折りたたみ傘を没収された…傘を刺されると混雑していて危険ということなのだろう。

keynoteの2時間前には入場して、1時間半前にはアンフィシアターに入ったが前列は既にいっぱいで後ろに誘導されてしまった。アンフィシアターは屋根が半分くらいしかないので、後ろの席は直射日光が凄まじくサウナ状態だったので次回はもっと早く行ったほうが良さそう。 2日目も2時間前には会場に行ったが行列だった。

今年の主要テーマ

今年の発表では、From research to reality というテーマでGeminiを中心としたAIの進化とそれが人々の生活にどう役立つかに焦点を当てているとのことで、これまでの研究を実際に製品に繋げる取り組みが多数紹介された。

- Google Beam

- 3Dビデオ通話ができ、会議中のハンドジェスチャーや製品紹介などをオンライン越しでもよりリアルに体験できるように。

- Gemini Live

- カメラ越しにリアルタイムでAIに話しかけ、カメラ越しに映った内容についてのコンテキストを持った状態で会話できる。

- 視覚障害がある方でもカメラ越しに周囲を映すことで、AIが音声で周囲の状況を説明するなど、AIが人間の機能の一部を代替するデモが印象的だった。

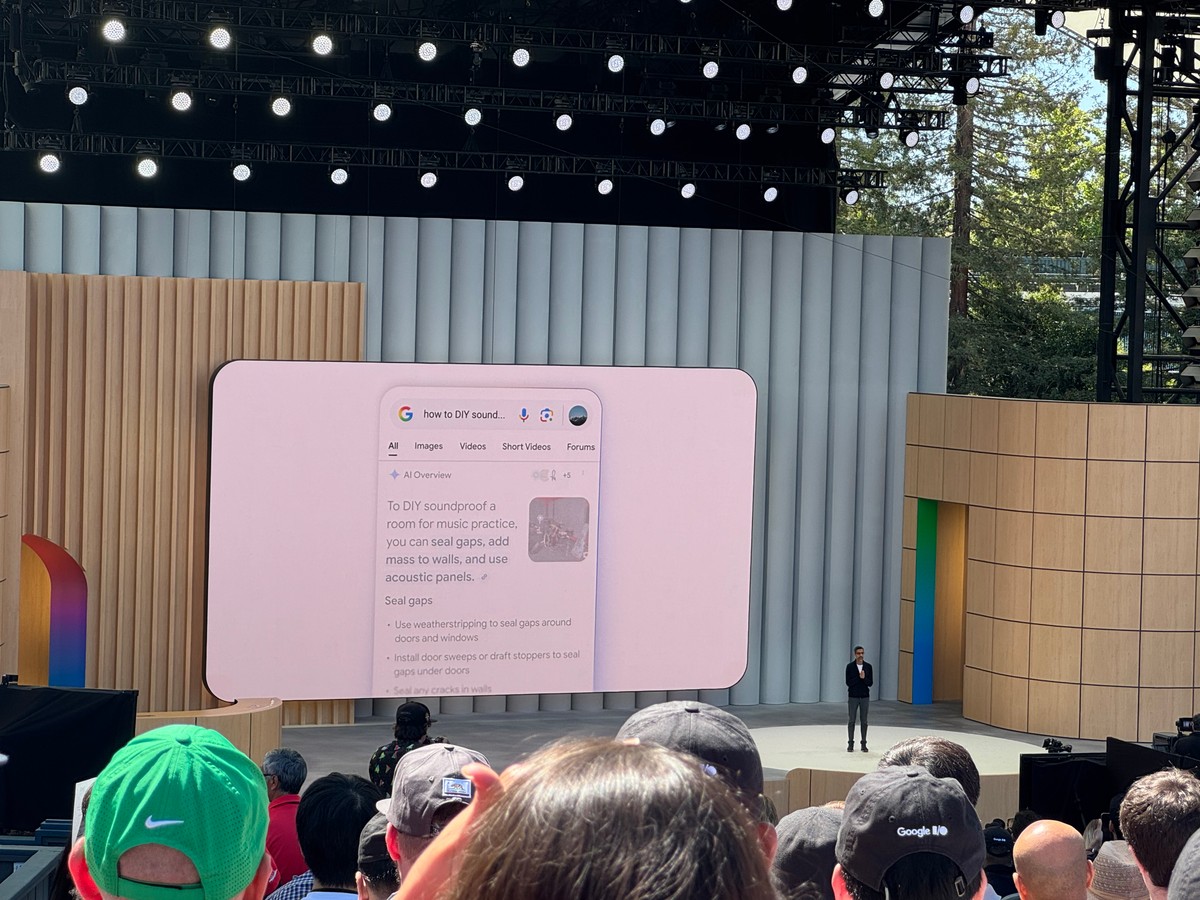

- Google Searchにおける AI Mode での検索

- 検索ではなくAIに直接話しかけて、そのフィードバックが検索結果に表示される。結果はダイナミックにUIが変化して、その内容をもとにさらにAIに質問することも可能。

- ショッピングやツアーの予約などもプロンプト越しに可能。

- Imagen、Veo → Flow

- ImagenやVeoなどの生成AIを実行できるサービスとしてFlowが登場。画像やプロンプトをもとに映像を出力することができる。

- Imagenはテキストの生成にも対応したためポスターやフライヤーなどをプロンプトから直接生成可能。

- Android XR

- Gemini Liveと相性が良く、カメラ越しに翻訳を行うデモが紹介される。

- アプリ開発自体もAdaptive Layoutに対応するとXRなどのデバイスで標準で動作することができる。

- Gemmaverse / Sign Gemma / Dolphin Gemma

- Gemmaを中心とした様々なチューニングモデルやツール群、エコシステムが生まれている。

- 手話やイルカとの会話にチューニングしたモデルが紹介され、将来的に他の動物との会話もできるようになる可能性があるとのこと。

- etc…

中でもGemini Liveを利用した自転車の修理を行う映像は、Googleが考えている未来の様子が伝わり、個人的にも最も印象的だった。

開発へのAIの活用

プロダクト開発における様々な分野に対して、コーディング支援や自立型エージェントなどのAIを活用したツールが紹介された。

- Stitch

- プロンプトからデザインを生成してFigmaにexportできる。

- プロトタイピングやデザイナーが不在な個人開発で重宝しそう。

- Jules

- 非同期のコーディングエージェント。GitHubと統合してリポジトリのコードベースを理解して自立して開発してくれる。

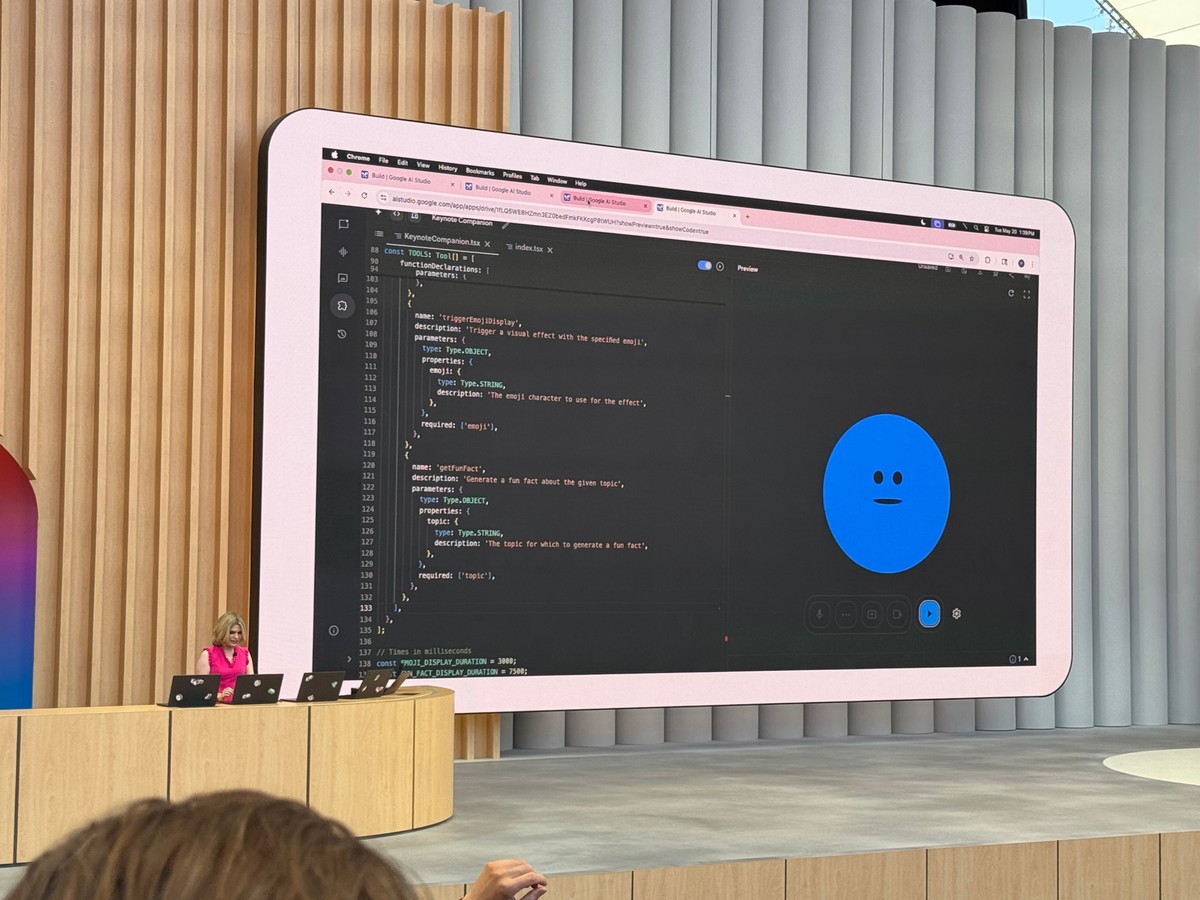

- Google Ai Studio

- MCPをサポートした他、オーディオモデルが搭載されたことにより、音声ベースでAI操作が実行可能に。

- Gemini in Android Studio

- 自然言語でAndroidデバイスを操作したり、ライブラリアップデートやクラッシュの修正についてもアシストしてくれる。

- Firebase Studio

- フロントエンドやFirebaseを利用した認証データ保存のアプリケーションをフルスタックで構築してくれる。

Julesはまだベータということもありこれからという印象がありますが、これでGoogleも自立型のコーディングエージェントを提供するようになり、Codex、Copilot Coding Agent、Claude Code Actionに加えて Devinへの競合プロダクトが一気に出揃ってきました。Googleのどの分野でも競合に優位性を譲らない姿勢を感じた。

デザインから開発までやってくれるようになり、新規サービス開発においては、仲間を集めるよりは1人でAIに課金してバリバリ作るという開発体制になっていきそう(すでになってるかも)。

Androidに関する新機能

Android 16では明らかにiOSのLive Activitiesを意識したLive Updatesがリリースされる他、Apple Vision Proへの対抗としてXREALやSamsungのデバイスが発表されたりと、ここでも競合を意識した新機能が発表された。

Jetpack Composeも大幅にパフォーマンス向上。最新のライブラリではジャンクレートが2%になり、Pixel 3Aなどの古いデバイスでも高いパフォーマンスが出せるよう改善されたとのこと。Android XRの他、車載用のデバイスで動作するようにできる Adaptive Layoutを実現するための機能がJetpack ComposeやMaterial 3へ増えていくことから、よりJetpcak Composeへ移行するモチベーションを高めてもらおうという狙いもありそう。

ブースの様子など

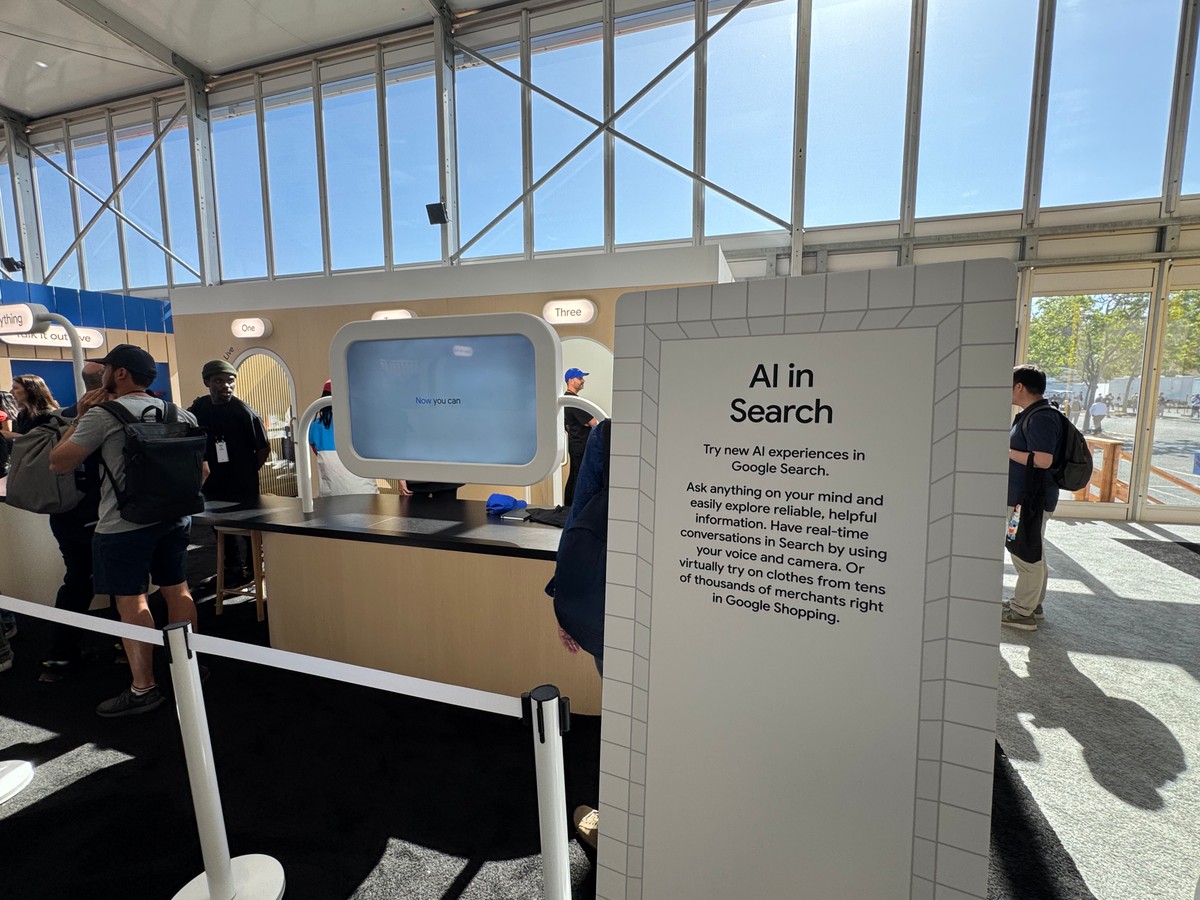

セッションの裏ではブースの展示が行われており、keynoteで発表された技術を実際に体験できる。

AI Sandbox

最も人気だった & 巨大な展示会場。中ではGeminiと組み合わせて提供されるプロダクトを実際に体験できる。

Gemini Roboticsを利用して、アームを自然言語で操作する展示や、バスケットボールのコーチをGeminiがやってくれ特典をカウントしてくれたり、AI Modeの体験や、スマートグラスの体験、Flowの体験などが用意されていた。

特にスマートグラスの体験は行列が常にいっぱいで、並ぶことすら許されなかった。

Google Beam

予約制で中は撮影禁止だったが、ブース内では担当者と通話ができ、裸眼で3Dのテレビのようなモニターを利用したビデオ通話が体験できた。 体感としては、Nintendo 3DSを初めて体験した時のイメージ。

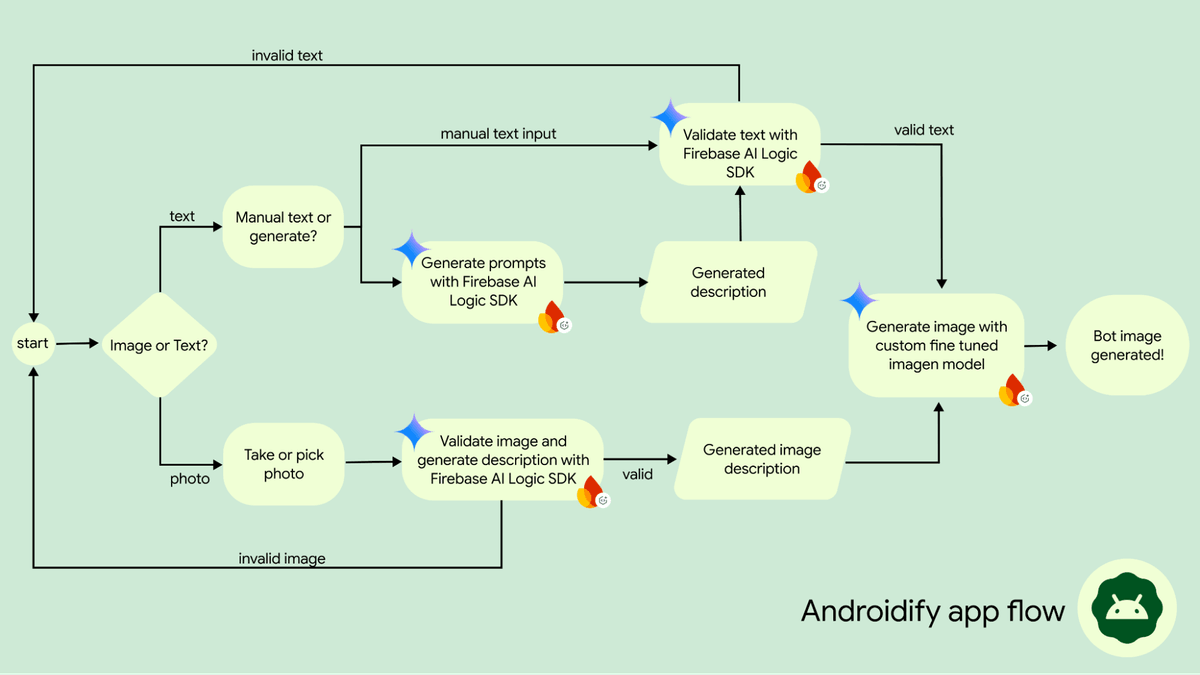

Androidify

自身の写真を撮影すると、その写真をもとにImagenを利用してオリジナルのドロイドくんを生成できる。作成したドロイドくんのステッカーを出口で貰えた。

Firebase AI Logic SDK経由で動いているとのことで、具体的なフローについても紹介されていた。

OSSでも公開されている。 https://github.com/android/androidify

Veo Booth

自身の写真を撮影し、絵文字を選択するとその絵文字に対応したエフェクトの動画をVeoが自動生成してくれる体験ブース。

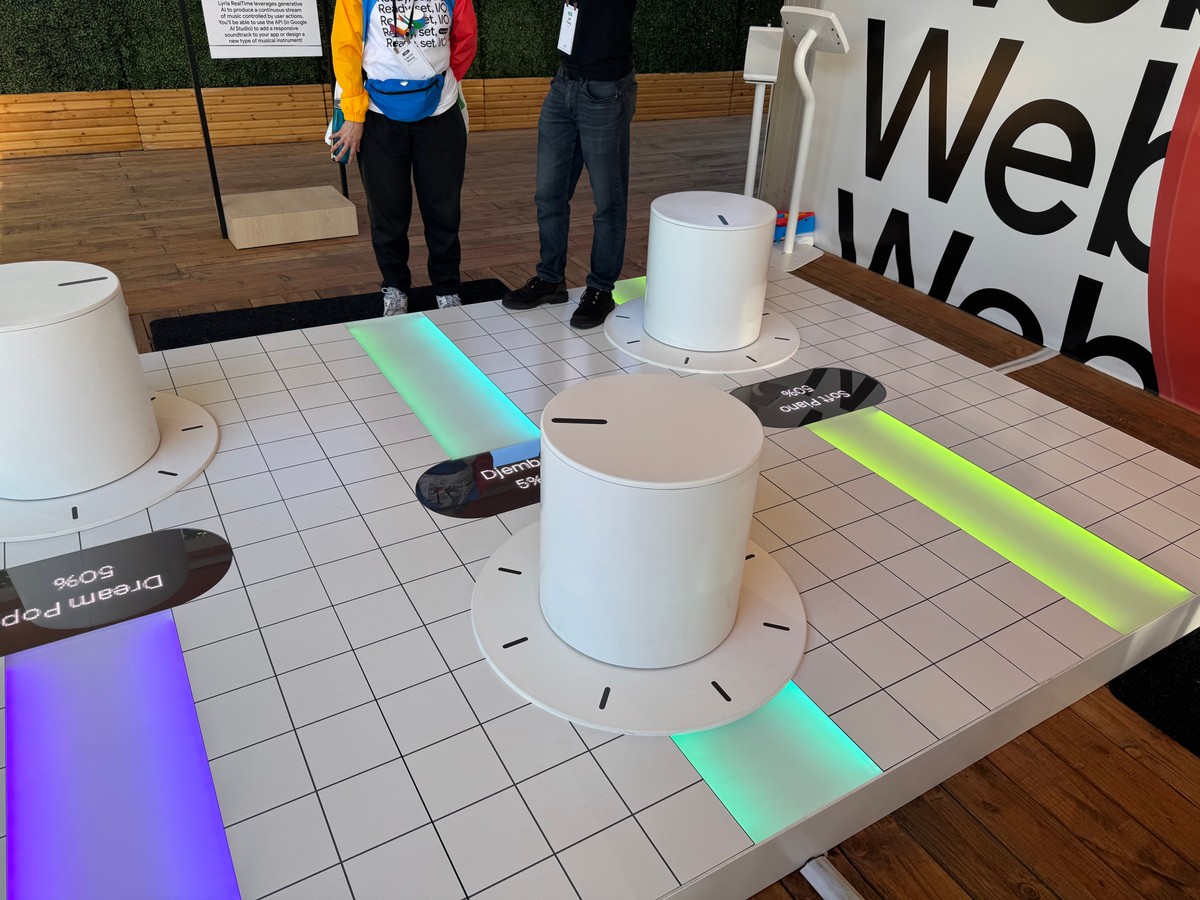

Lyria RealTime

Lyriaを利用した音楽のリアルタイム生成を体験できる。 座ってノブを操作できて、ノブをいじるとリアルタイムにプロンプトが変更されて流れている音楽が変化する。

Acid House 99%にしてみたが、あまりTB-303っぽいウネウネは聞けなかったので他のプロンプトも変えないといけなかったかも。

Waymo

Waymoも展示されており、中に乗ったり仕組みの説明などしてもらえる。

XR Headsets

VR体験のブースもあったが、予約制でいっぱいで入れず。

Geminiと統合されていることで音声で操作できるため、VRならではの画面操作が若干面倒なポイントをAIがいい感じにしてくれるらしい。

Adventure Quest

会場内にはQRコードを読み込んでエリアを回るスタンプラリーもあった。達成するとピンバッジが貰えた他、AIが生成したTシャツが後から届くらしい。

感想

GeminiやGemmaを利用するかはさておきとして、Google がAIへ質問することをベースとしたユーザー体験に舵を切ったことで、検索のインターフェースに限らずユーザーが最初に触れるインターフェースが自然言語での問い合わせになっていくように思う。サービスの機能開発においても、開発者がニーズのありそうなコンテンツを提供するというよりは、ニーズに対してピンポイントで欲しい情報を届けることがより一層求められるようになるようになりそう。

また、Android XR搭載のスマートグラスは、VRヘッドセットの課題であった普段使いのしづらさをどれだけ解消できるか、Metaのスマートグラスのような使い所が限られる点をAndroidエコシステムが利用できることでどれだけ便利にできるかが鍵になりそう。デバイスについてはGoogle Glassやタブレットなど力を入れたり撤退したりを繰り返している歴史があることからも、現時点ではこれが流行るかは分からないが、一般ユーザーに普及すればスマートフォンに変わりうるデバイスになっていく可能性のある分野と思う。

正直参加前は、「AI疲れ」ではないがどうせGemini関連の発表ばかりなのだろう、それよりは開発にピンポイントで使えるようなAPIやツールが提供されないかを期待して参加していた。しかし、実際参加してみると予想通りAIばかりな一方で、他の新機能発表が霞むくらいGoogleの描くAIの未来が自身をワクワクさせてくれるもので、とても刺激的な体験でとても良かった。